-

Snowflake の Copilot が優秀すぎる件について

こんにちは、喜田です。いままでSnowflakeのライトユーザーで一部機能だけに特化して触っている状態でしたが、最近はData Superheroes 2024になったこともあり、いままで関わりの薄かった製品領域も調査したり、海外リージョンでしか出ていないプレビューを触ったりしています。そのうちの一つがCopilotで、いまは北米など一部リージョンでのみパブリ…

-

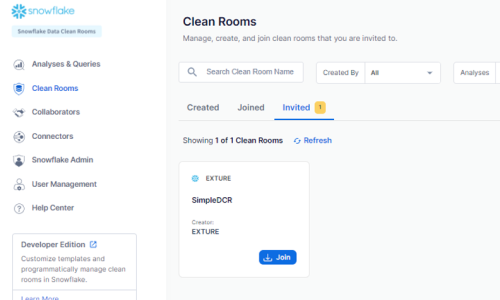

Snowflake の新しいData Clean Roomの見どころを解説

こんにちは、喜田です。私は昨年Snowflakeのデータクリーンルームに関する案件経験を発信して、SnowflakeのDataSuperheroes 2024…

-

【GA4/GTM】dataLayerを使ってカスタムイベントを発生させてみよう

はじめに以前の記事でdataLayerを使用し、GTMとのデータの受け渡しを書きました。まだ見てないよ〜という方は是非ご覧ください。…

-

-

【GA4/GTM】dataLayerを活用しよう

はじめにこんにちは、エクスチュアの岩川です。GA4のdataLayer、活用していますか?dataLayerを上手く使うことでGA4で…

-

ジャーニーマップをデジタルマーケティングの視点で

顧客体験をより良いものにするために、様々なツールやメソッドがあります。本日は、その多くあるメソッドの一つであるジャーニーマップをご紹介します。今回は特…

-

ChatGPT ProからClaude3 Proへ移行した話

こんにちは、エクスチュアの黒岩です。突然ですが、皆様はどんな生成AIサービスを使用していますか?ChatGPT、Google Gemini、Micro…

-

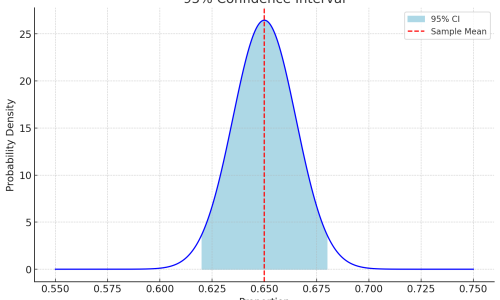

その分析、やり方あってる?記述統計と推測統計の違い

こんにちは、小郷です。閲覧数のために挑発的なタイトルでイキりました(正直)。さて、このページに辿り着いている方であれば、データ分析とかデータドリブン経…

-

Mouseflowのセッションリプレイのしくみ

皆さんこんにちは。菅原です。今回は、ユーザー行動分析ツール Mouseflow のメイン機能の一つである 「セッションリプレイ」機能について少し掘り下げていき…

-

LangChainって何?: 次世代AIアプリケーション構築 その2

こんにちは、エクスチュアの石原です。こちらは第2回の記事になっております。前回の記事をご覧になっていない方は、ぜひ前回の記事からお読みください。…

DTM(Dynamic Tag Manager)って何?

DTM(Dynamic Tag Manager)って何?

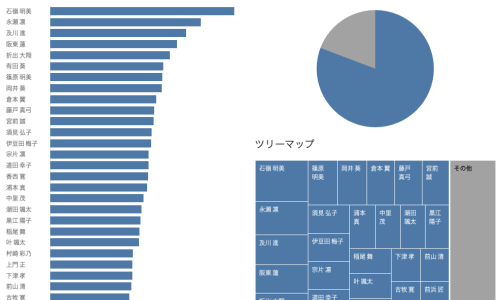

上位N件セットを使って「その他」を効果的に表現する【Tableau】

上位N件セットを使って「その他」を効果的に表現する【Tableau】

CAD・CAM・CAEって何?

CAD・CAM・CAEって何?

Adobe Analytics 原理①

Adobe Analytics 原理①